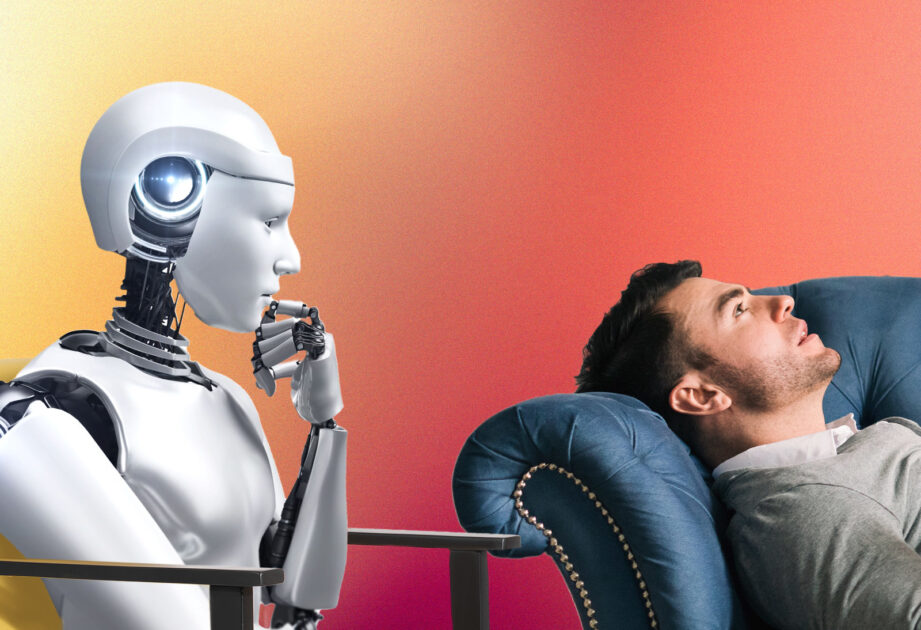

AI ذہنی صحت کے بوٹس اکثر اخلاقی اصولوں کی خلاف ورزی کرتے ہیں، جس سے مضبوط نگرانی کا مطالبہ کیا جاتا ہے۔

چونکہ لوگوں کی بڑھتی ہوئی تعداد ChatGPT اور دیگر بڑے لینگویج ماڈلز (LLMs) سے ذہنی صحت کی مدد حاصل کرتی ہے، نئی تحقیق سے پتا چلا ہے کہ یہ نظام، ثبوت پر مبنی علاج کے طریقوں پر عمل کرنے کی ہدایت کے باوجود، اکثر امریکی سائیکولوجیکل ایسوسی ایشن جیسی تنظیموں کے مقرر کردہ اخلاقی معیارات کو پورا کرنے میں ناکام رہتے ہیں۔

دماغی صحت کے پیشہ ور افراد کے تعاون سے براؤن یونیورسٹی کے کمپیوٹر سائنس دانوں کی سربراہی میں ہونے والی اس تحقیق نے انکشاف کیا کہ ایل ایل ایم پر مبنی چیٹ بوٹس متعدد اخلاقی خلاف ورزیوں کا ارتکاب کر سکتے ہیں۔

ان میں بحران کے حالات کو غلط طریقے سے سنبھالنا، گمراہ کن تاثرات پیش کرنا جو نقصان دہ خود شناسیوں کو تقویت دیتا ہے، اور ہمدردی کا وہم پیدا کرنا جس میں حقیقی فہم کا فقدان ہے۔

“اس کام میں، ہم 15 اخلاقی خطرات کا ایک پریکٹیشنر سے باخبر فریم ورک پیش کرتے ہیں تاکہ یہ ظاہر کیا جا سکے کہ کس طرح ایل ایل ایم کے مشیر دماغی صحت کی مشق میں اخلاقی معیارات کی خلاف ورزی کرتے ہیں اور ماڈل کے رویے کو مخصوص اخلاقی خلاف ورزیوں کے ساتھ نقشہ بناتے ہیں،” محققین نے اپنے مطالعے میں لکھا۔

“ہم LLM مشیروں کے لیے اخلاقی، تعلیمی، اور قانونی معیارات بنانے کے لیے مستقبل کے کام پر زور دیتے ہیں – ایسے معیارات جو انسانی سہولت فراہم کرنے والی سائیکو تھراپی کے لیے درکار نگہداشت کے معیار اور سختی کے عکاس ہوں۔